Calcolo

Un complesso sistema distribuito di grid-computing per l’elaborazione e l’analisi dell’enorme mole di dati prodotta

Il successo del programma di fisica dell’esperimento CMS dipende in modo critico dalla disponibilità di risorse di calcolo sufficienti per elaborare, archiviare e analizzare campioni di dati simulati e dati da collisioni in modo tempestivo.

CMS esegue una varietà di applicazioni sulla sua infrastruttura informatica distribuita per ricostruire e simulare i dati di collisione e analizzare entrambi.

L’esperimento CMS ha riportato numerosi successi durante le prese dati di LHC denominate Run 1 e Run 2, fornendo una varietà di entusiasmanti risultati scientifici attraverso l’analisi di collisioni sia di protoni che di ioni pesanti. Almeno tre fattori nel software e nel calcolo di CMS sono stati fondamentali per un tale successo. Il primo è lo sviluppo di un sistema performante e flessibile per lo sviluppo di applicazioni scientifiche e una comunità sperimentale di sviluppatori di algoritmi dedicatasi con impegno alla causa: tale combinazione ha portato alla creazione di una piattaforma software moderna, all’altezza delle sfide poste dal programma di fisica di CMS. Il secondo è lo sviluppo e il funzionamento di software e servizi informatici per orchestrare dati e flussi di lavoro. Il terzo è la quantità adeguata di risorse informatiche per archiviare, elaborare e analizzare i dati in modo efficiente.

Il CMSSW è il software di CMS ed è costituito da quasi 8 milioni di righe di codice elaborate negli ultimi 15 anni.

In CMSSW, gli algoritmi di elaborazione dei dati sono scritti in C++ e contengono codice per il trigger di alto e basso livello, generatori di particelle, workflow offline per processare dati e simulazioni Monte Carlo, nonché codice di analisi dati.

CMSSW viene utilizzato in quasi tutte le attività eseguite nell’infrastruttura di elaborazione distribuita mondiale le cui risorse sono federate in un pool di mezzo milione di core.

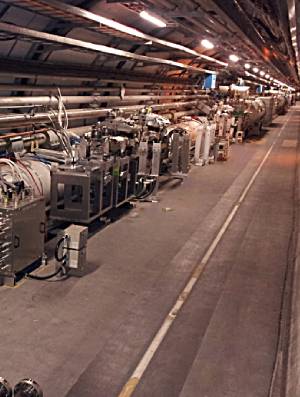

L’infrastruttura distribuita, parte del sistema WLCG, è composta da più di 70 centri organizzati in una struttura gerarchica di livelli di calcolo (Tier). Un singolo centro di livello 0 al CERN (Tier-0) accetta i dati dal sistema di acquisizione dati online di CMS per l’archiviazione, la calibrazione e la ricostruzione in tempo reale.

Il livello 0 distribuisce i dati grezzi ed elaborati a un insieme di grandi centri di livello 1 (Tier-1) per l’archiviazione secondaria, l’elaborazione dei dati organizzata e il servizio di dati a un insieme più numeroso di centri di livello 2 più piccoli (Tier-2).

I centri di livello 2 forniscono risorse per attività di analisi, calibrazione e simulazione Monte Carlo. I nuovi dati prodotti a livello 2 vengono trasferiti a livello 1 per l’archiviazione custodiale.

Oltre al design originale del modello di calcolo di CMS, la continua evoluzione tecnologica negli ultimi decenni ha permesso di superare il modello originale, offuscando i ruoli di Tier-1 e Tier-2 riducendo le differenze funzionali tra i Tier. Ciò ha garantito un elevato livello di flessibilità nel tipo di attività che possono essere eseguite a ciascun livello di Tier.

I principali compiti tipicamente eseguiti sull’infrastruttura sopra menzionata sono i seguenti.

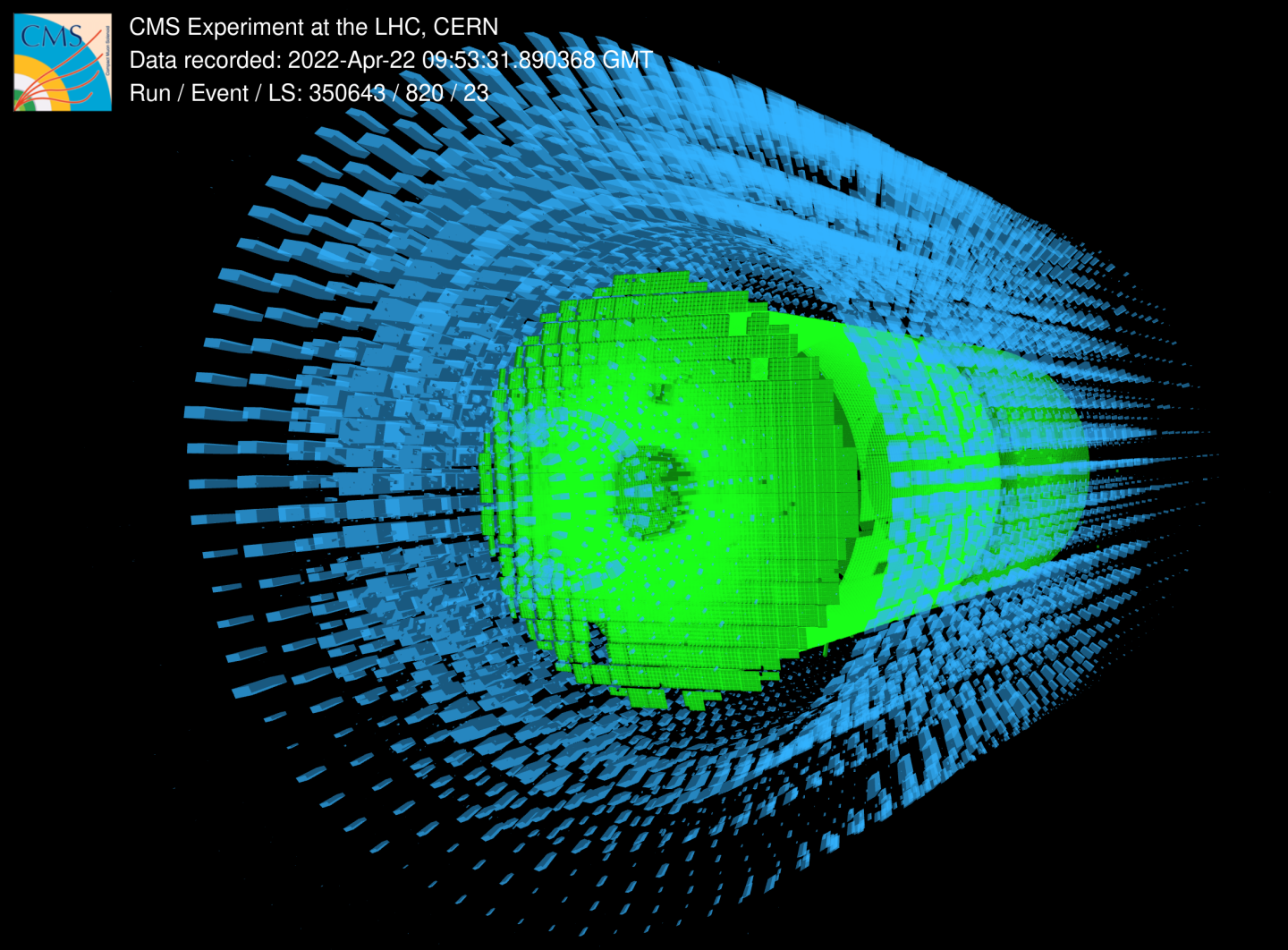

Dapprima avviene la simulazione dei dati di collisione come primo passo che prende l’output della generazione di eventi e modellizza la deposizione di energia delle particelle che interagiscono con il materiale nel rivelatore di CMS.

La digitalizzazione, quindi, è il passaggio successivo, atto a modellizzare l’elaborazione elettronica del segnale prodotto dalle deposizioni di energia nel rivelatore. Questo passaggio simula anche l’effetto di interazioni protone-protone aggiuntive.

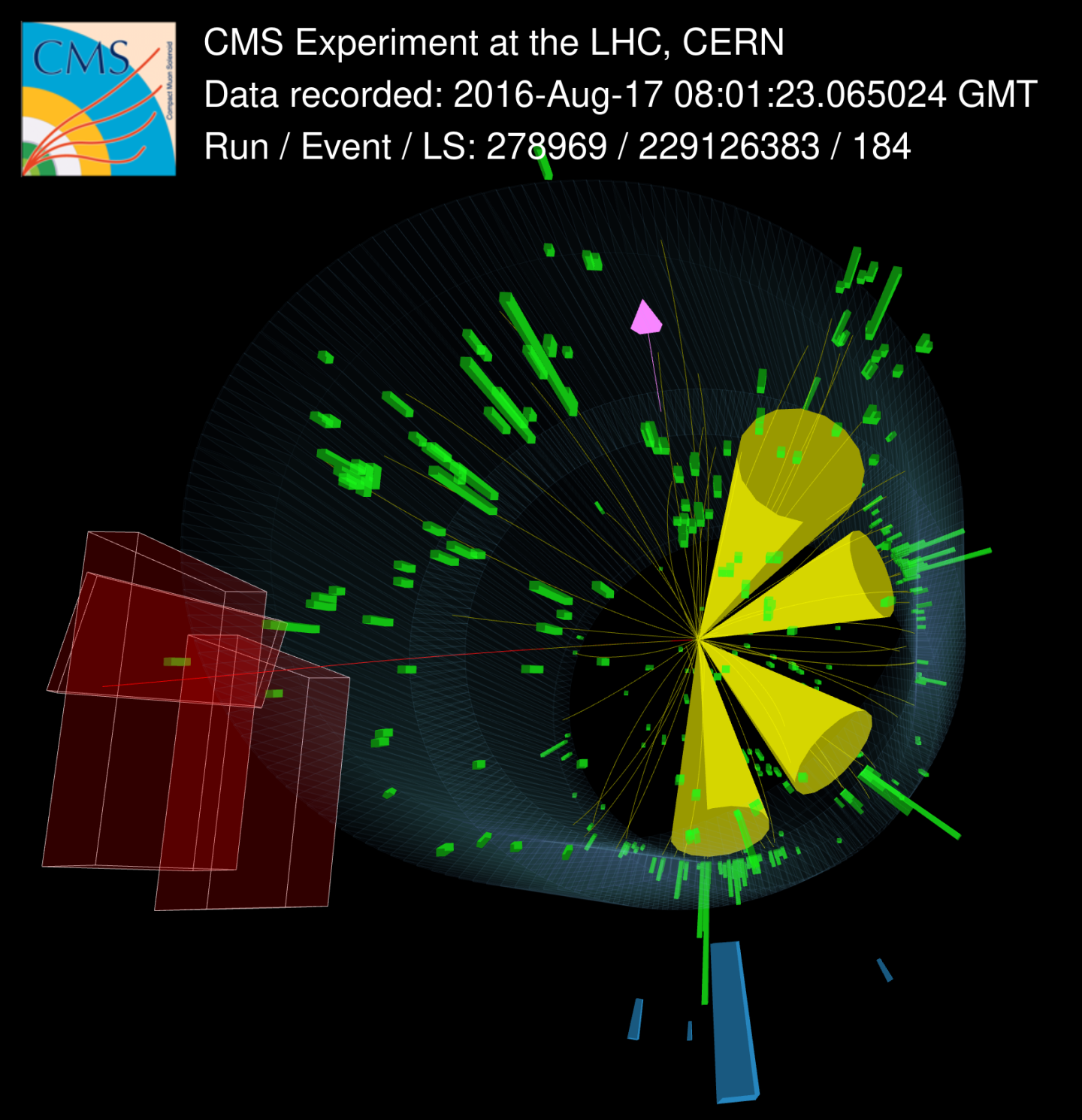

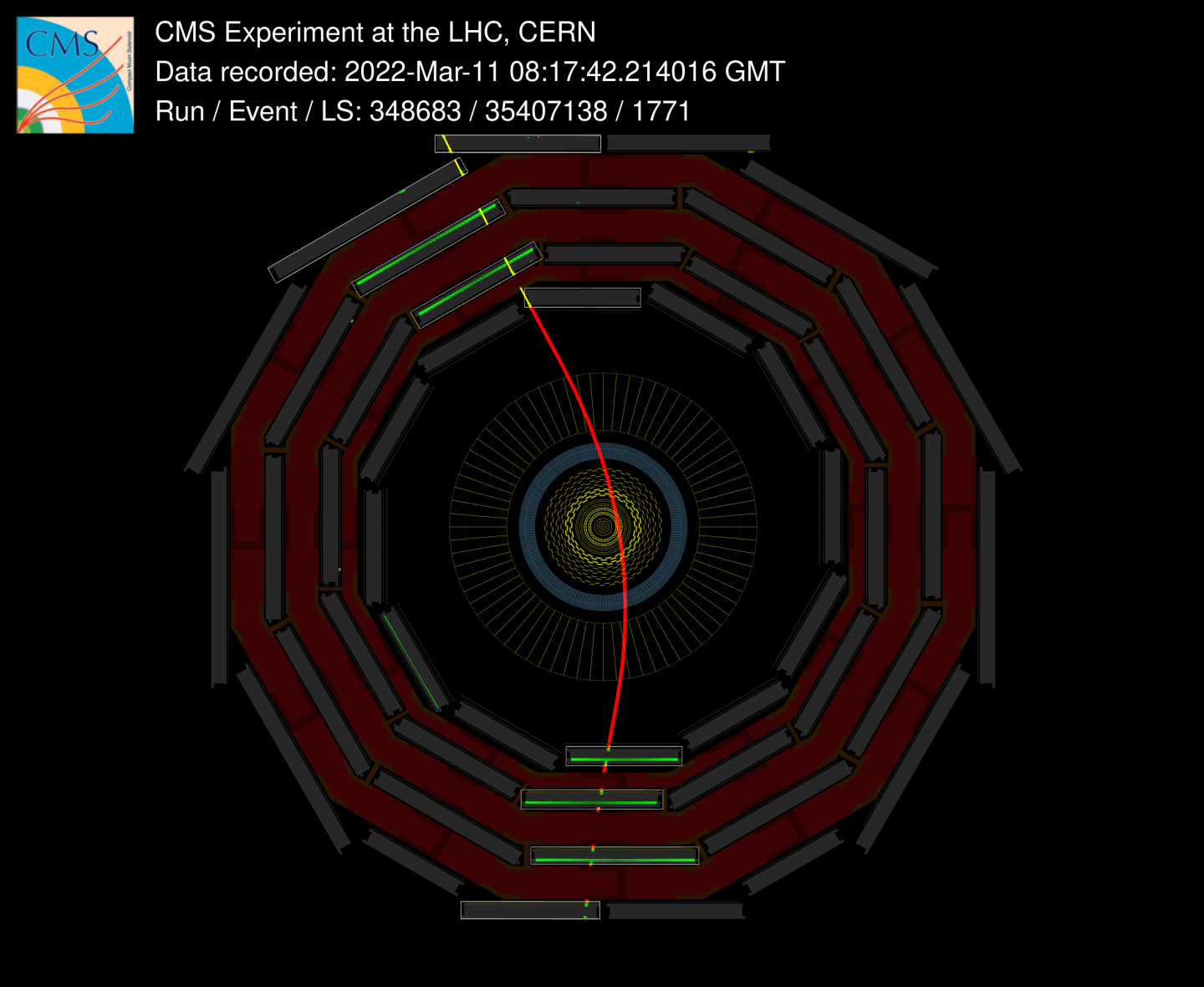

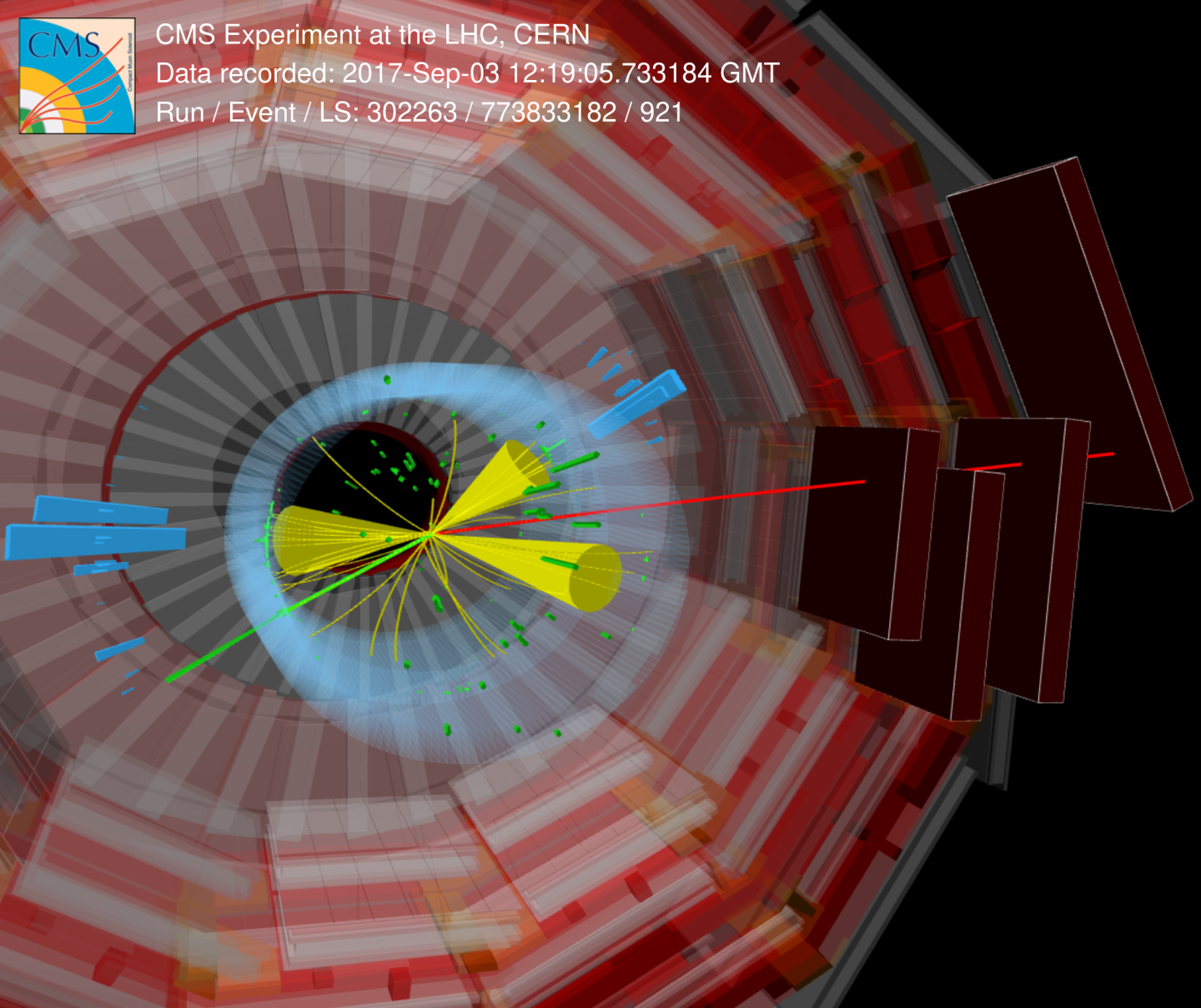

La ricostruzione esegue tutti gli algoritmi necessari per interpretare i segnali come dovuti all’interazione di particelle identificabili con il rivelatore.

Infine, l’analisi di alto livello riduce la dimensione dell’output della ricostruzione attraverso il filtraggio degli eventi e l’eliminazione delle informazioni non necessarie per una particolare misura fisica. Le proprietà degli eventi specifici vengono quindi calcolate e le informazioni vengono ridotte a istogrammi o grafici, portando all’interpretazione statistica finale dei risultati.

Il sistema informatico complessivo nel 2022 conta 2.500 kHS06, circa 200 PB di spazio su disco e circa 400 PB di nastro. per un totale di 600 PB, cioè 600 milioni di GB (1 Petabyte equivale a 1 milione di Gigabyte).

L’Italia è uno dei maggiori contributori con il 13% della potenza di calcolo e dello storage. Le risorse italiane sono distribuite su 5 centri di calcolo, 1 Tier-1 situato presso CNAF a Bologna e 4 Tier-2 (Pisa, Bari, Legnaro, Roma).

L’evoluzione futura del sistema software di CMS e del modello di calcolo è guidata dalla necessità di superare le sfide poste dai tassi di eventi e dalla complessità nell’era del cosiddetto “high-luminosity LHC”. Prevediamo che la frequenza degli eventi sarà 7,5 volte superiore a quella attuale, raggiungendo 7,5 kHz, il fenomeno dell’impilamento (pile-up) sarà aumentato di un fattore 5, raggiungendo 200 collisioni parassitarie per incrocio di pacchetti di protoni ed inoltre anche il rivelatore subirà degli upgrade.

Per far fronte a queste condizioni, sarà necessaria una quantità senza precedenti di risorse informatiche (CPU circa 6 volte superiore, mentre le esigenze di dischi e nastri sono rispettivamente circa 2,5 e 4 volte superiori). Per mitigare questi requisiti senza ridurre il potenziale fisico degli esperimenti CMS sono attualmente in corso diverse attività di ricerca e sviluppo. Esse vanno dall’adozione di tecniche di machine learning e intelligenza artificiale, integrazione di GPU e FPGA, federazione di nuovi tipi di strutture come Cloud e centri HPC fino alla riduzione delle esigenze di storage su disco e delle esigenze di rete.

Compiti dell'Infrastruttura

I principali compiti tipicamente eseguiti sull’infrastruttura sopra menzionata sono i seguenti.

Dapprima avviene la simulazione dei dati di collisione come primo passo che prende l’output della generazione di eventi e modellizza la deposizione di energia delle particelle che interagiscono con il materiale nel rivelatore di CMS.

La digitalizzazione, quindi, è il passaggio successivo, atto a modellizzare l’elaborazione elettronica del segnale prodotto dalle deposizioni di energia nel rivelatore. Questo passaggio simula anche l’effetto di interazioni protone-protone aggiuntive.

La ricostruzione esegue tutti gli algoritmi necessari per interpretare i segnali come dovuti all’interazione di particelle identificabili con il rivelatore.

Infine, l’analisi di alto livello riduce la dimensione dell’output della ricostruzione attraverso il filtraggio degli eventi e l’eliminazione delle informazioni non necessarie per una particolare misura fisica. Le proprietà degli eventi specifici vengono quindi calcolate e le informazioni vengono ridotte a istogrammi o grafici, portando all’interpretazione statistica finale dei risultati.

Il sistema informatico complessivo nel 2022 conta 2.500 kHS06, circa 200 PB di spazio su disco e circa 400 PB di nastro. per un totale di 600 PB, cioè 600 milioni di GB (1 Petabyte equivale a 1 milione di Gigabyte).

L’Italia è uno dei maggiori contributori con il 13% della potenza di calcolo e dello storage. Le risorse italiane sono distribuite su 5 centri di calcolo, 1 Tier-1 situato presso CNAF a Bologna e 4 Tier-2 (Pisa, Bari, Legnaro, Roma).

L’evoluzione futura del sistema software di CMS e del modello di calcolo è guidata dalla necessità di superare le sfide poste dai tassi di eventi e dalla complessità nell’era del cosiddetto “high-luminosity LHC”. Prevediamo che la frequenza degli eventi sarà 7,5 volte superiore a quella attuale, raggiungendo 7,5 kHz, il fenomeno dell’impilamento (pile-up) sarà aumentato di un fattore 5, raggiungendo 200 collisioni parassitarie per incrocio di pacchetti di protoni ed inoltre anche il rivelatore subirà degli upgrade.

Per far fronte a queste condizioni, sarà necessaria una quantità senza precedenti di risorse informatiche (CPU circa 6 volte superiore, mentre le esigenze di dischi e nastri sono rispettivamente circa 2,5 e 4 volte superiori). Per mitigare questi requisiti senza ridurre il potenziale fisico degli esperimenti CMS sono attualmente in corso diverse attività di ricerca e sviluppo. Esse vanno dall’adozione di tecniche di machine learning e intelligenza artificiale, integrazione di GPU e FPGA, federazione di nuovi tipi di strutture come Cloud e centri HPC fino alla riduzione delle esigenze di storage su disco e delle esigenze di rete.

CMS VISTO DA VICINO

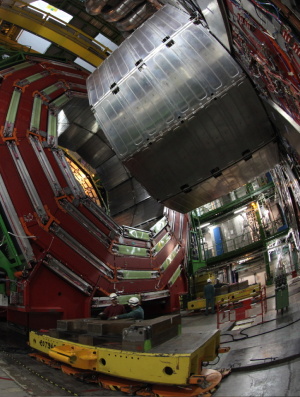

Il Magnete

Con un campo magnetico di ben 4 Tesla, ossia 100.000 più forte di quello terrestre, ha il compito di ...

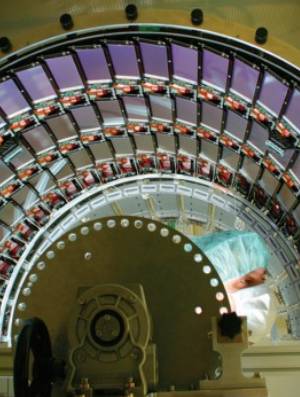

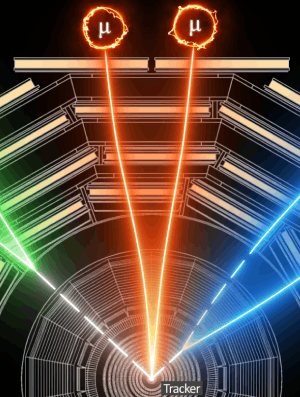

Il Tracciatore

Ricostruisce le traiettorie delle particelle misurandone le posizioni. Può ricostruire le traiettorie di ...

I Calorimetri

Divisi in due grandi categorie, ECAL e HCAL, convertono l'energia delle particelle incidenti in un segnale che ...

Le Muon Chamber

Collocate all'esterno del magnete, si dividono in 4 "stazioni" collocate a distanza crescente dal punto ...

Lo Spettrometro di Precisione per Protoni

Posto a 200mt dal punto di collisione, il CT-PPS è un rivelatore di protoni installato all’esperimento CMS all’LHC del CERN di Ginevra allo scopo di ...

Il Trigger & DAQ (Data Acquisition)

Il sistema di “trigger” deve riconoscere gli eventi di fisica interessanti e, in caso di scelta positiva, segnalare al sistema di lettura ...

La Sala di Controllo & Turni Presa Dati

La sala di controllo di CMS e' il cuore pulsante delle attivita' online da dove si coordina la presa dati di CMS, si mantiene in sicurezza il rivelatore, si ...

Calcolo & Grid Computing

Un complesso sistema distribuito di grid-computing per l'elaborazione e l'analisi dell'enorme mole di dati prodotta ...

Organizzazione e scienziati al lavoro sul progetto

L’esperimento CMS è una delle più grandi collaborazioni internazionali nella storia scientifica.

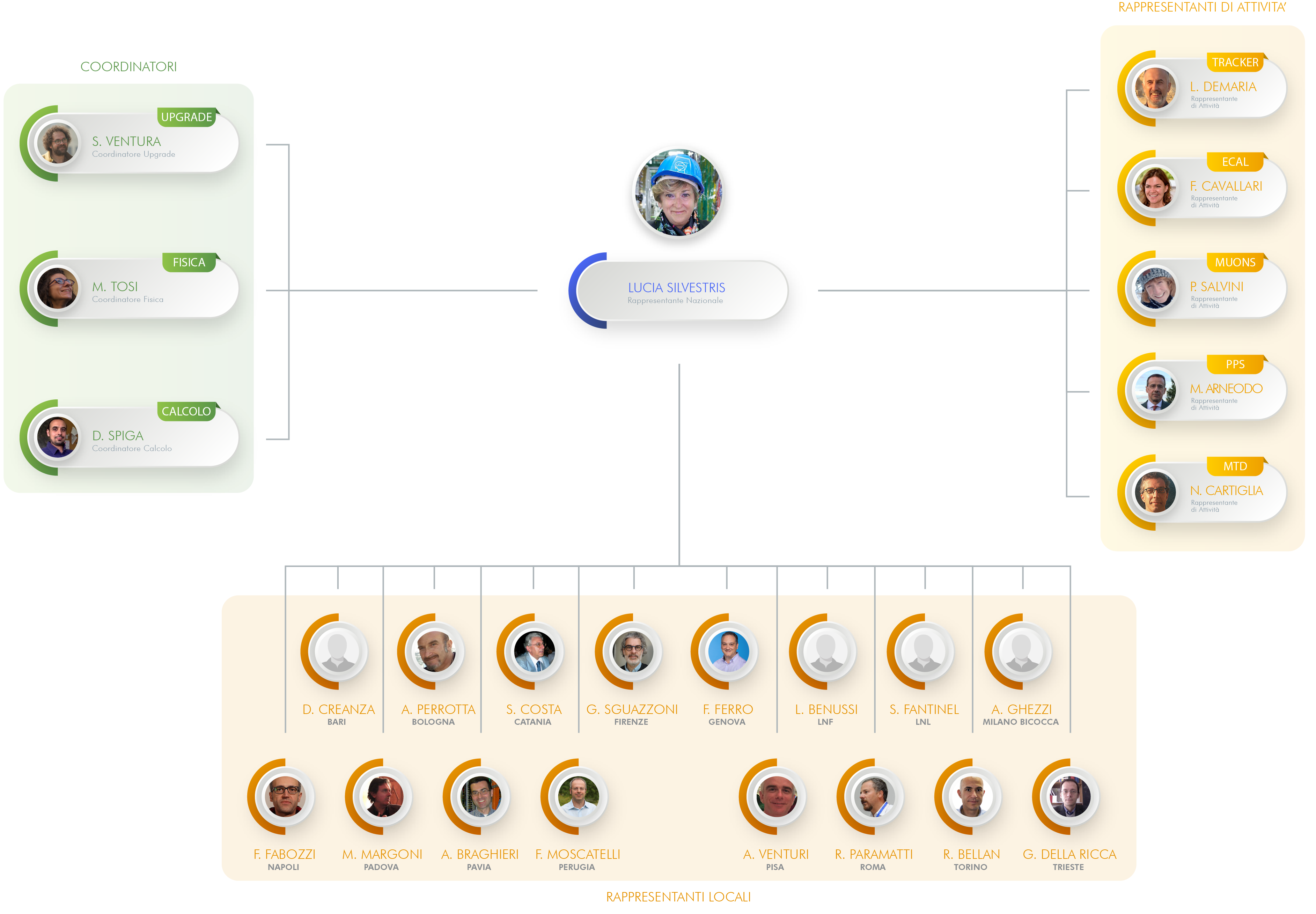

Team INFN

Oltre 250 fisici e ingegneri sono impegnati a lavorare all’esperimento ed hanno realizzato significative frazioni del sistema

Board Internazionali

- Management

- Finance

- Executive

Team Italiani e Worldwide

Il progetto si estende in oltre 54 paesi e regioni in tutto il globo, coinvolgendo 241 istituti, più di 3000 fisici, oltre 1000 ingegneri e circa 270 tecnici che collaborano quotidianamente per svelare i segreti dell'universo.

Archivi e Storia di CMS

Dal fuoco all'elettricità, le scoperte hanno plasmato la civiltà umana: la ricerca fondamentale è la forza trainante per migliorare le nostre vite. Nel 2012, CMS ha annunciato la sua prima grande scoperta, il bosone di Higgs, un tipo di particella mai vista prima.

Criteri di Selezione

La CMS Collaboration è un'organizzazione di istituzioni accademiche che hanno collaborato per costruire e far funzionare il rivelatore CMS. La procedura di accesso all'esperimento prevede in prima istanza l'esprimere interesse al CMS Spokeperson.

I Gruppi di Lavoro

L’esperimento CMS è una delle più grandi collaborazioni scientifiche internazionali della storia, che coinvolge 5000 tra fisici delle particelle, ingegneri, tecnici, studenti e personale di supporto di 200 istituti di cui 16 in Italia.

La "scoperta" del Bosone di Higgs

Ricorre nel 2022 il decimo anno di un evento storico: la rivelazione del bosone teorizzato da Peter Higgs e François Englert

Vuoi essere dei nostri?

Resta aggiornato sui nuovi sviluppi e sui prossimi eventi e iniziative o unisciti alla discussione